在这篇文章中我分享了去年9月我在纽约Strata数据会议上所发表主题演讲幻灯片和笔记。 随着数据社区开始部署更多机器学习(ML)模型,我想回顾总结一些重要的思考。

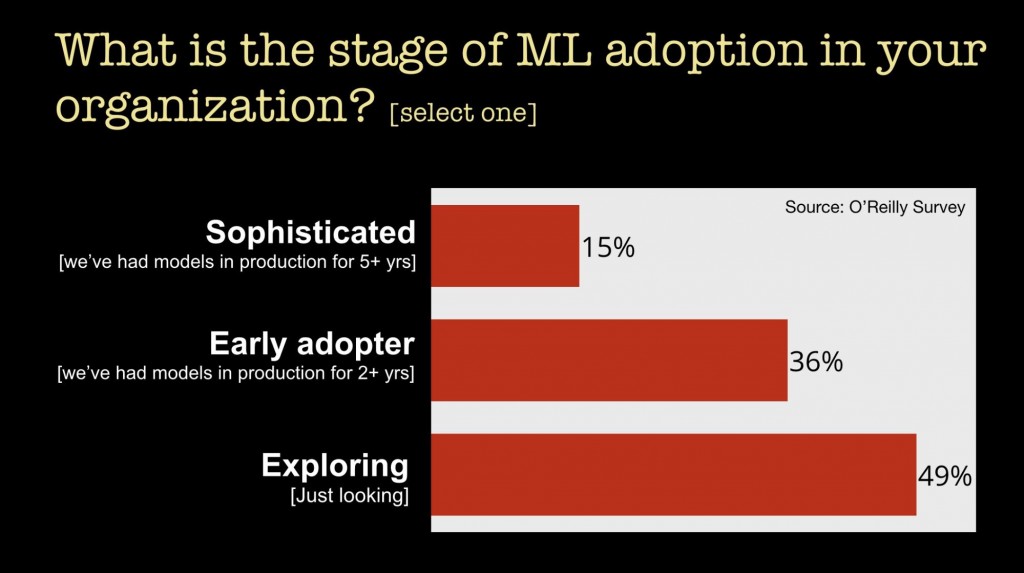

让我们首先看一下当前采纳机器学习的情况我们最近进行了一项调查,收集了超过11,000名受访者的答案—— 这个调查的主要目的是弄清楚企业如何使用机器学习。 我们学到的很多事情中的其中一件是,许多公司仍处于部署机器学习(ML)的早期阶段:

对于公司迟迟不予行动,保持回避的原因,我们从今年早些时候进行的一项调查中发现,公司认为缺乏技术人才,“技能差距”是阻碍接纳机器学习的主要挑战。

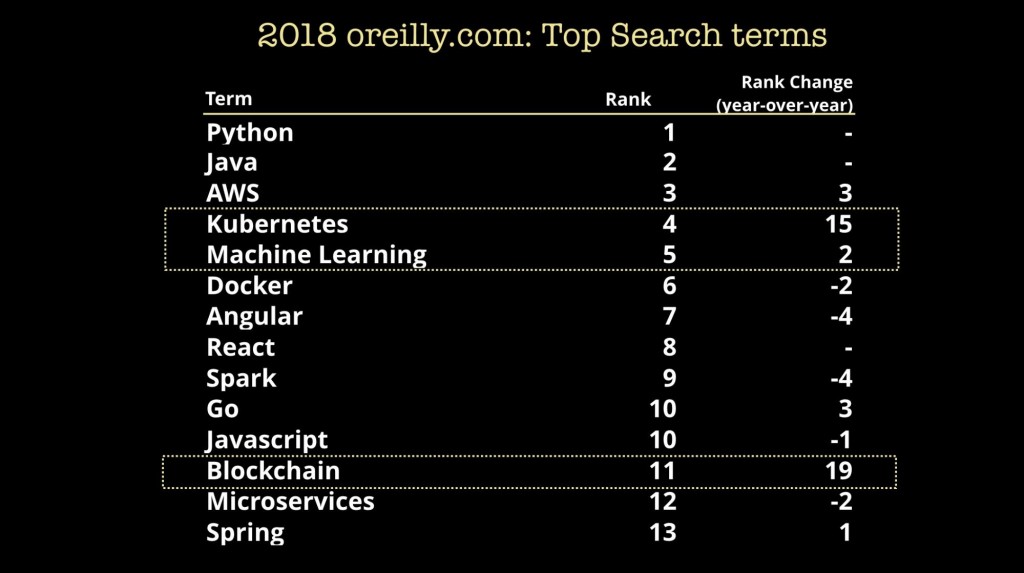

公司一侧感兴趣,意味着对“机器学习人才”的需求侧是健康的。 开发人员已经注意到,并开始了解机器学习。 在我们自己的在线培训平台(拥有超过210万用户)中,我们发现机器学习主题引起了读者的浓厚兴趣。 以下是我们培训平台上的热门搜索主题关键字:

除了“搜索”,值得注意的是,我们观察到看到所有媒体格式 —— 包括书籍,博文,视频和培训上,与机器学习相关内容的消费都有强劲增长。

在我继续之前,需要着重强调的是,机器学习不仅仅意味着建立模型。 在将许多模型部署到产品和服务之前,您的公司内部需要具备相应的文化,流程和基础架构。 在最近的Strata Data会议上,我们就相关的文化,组织和工程主题进行了一系列的讨论。 以下是最近会议中几个相关议题的列表:

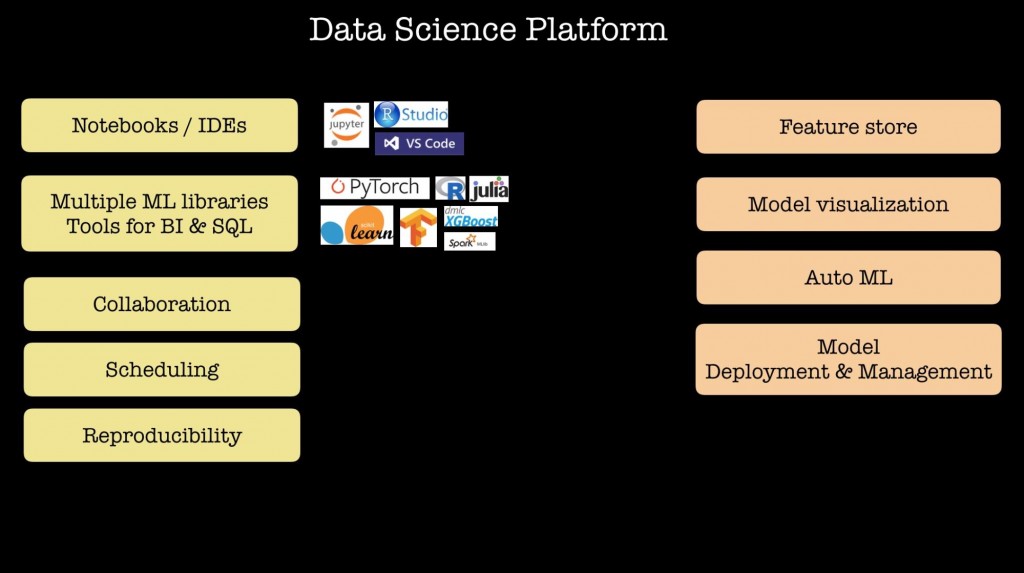

在过去的12-18个月中,使用大量机器学习并聘请数据科学家团队的公司一直在描述他们的内部数据科学平台(比如,参见Uber,Netflix, Twitter和Facebook)。它们共享我在下面列出的某些功能,其中包括为多个机器学习库和框架,笔记本工具,调度工具和协作工作提供支持。 一些公司在工具中纳入了高级功能,包括数据科学家分享机器学习模型中的某些特征(Feature指特征)的方法,自动搜索潜在模型的工具,甚至一些平台具备模型部署功能:

当您跨越了原型设计阶段,并且实际上开始部署机器学习模型时,随着这些模型开始与真实用户或设备交互,将会出现许多挑战。 David Talby在最近的一篇文章中总结了其中的一些核心的挑战:

- 您的模型可能会开始降低精度

- 需要定制模型(针对特殊的地理位置,文化情况,行业领域和应用)

- 真正的建模在部署到生产之后才开始

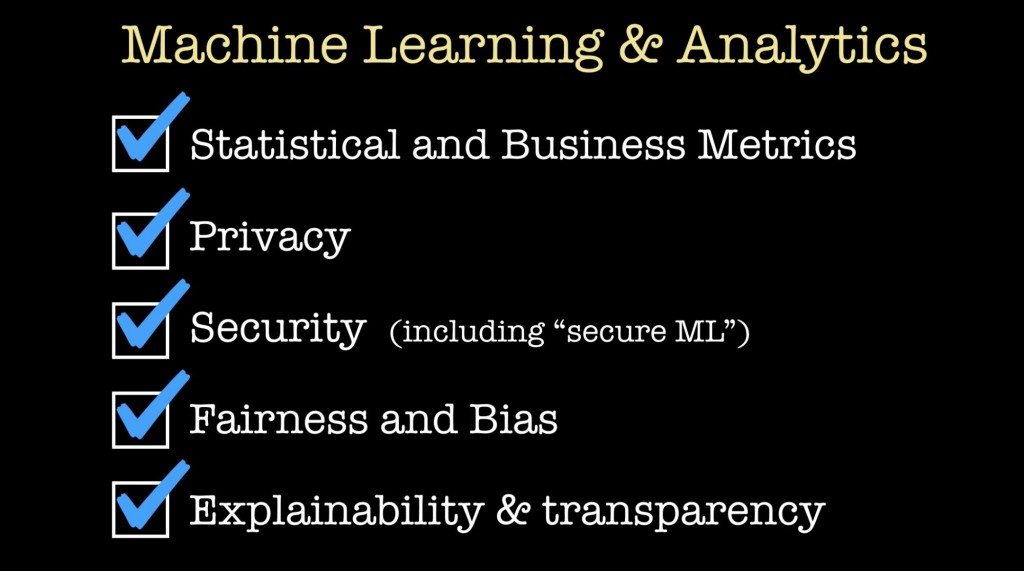

除了优化统计或量化指标之外,还有许多重要的考虑因素。 例如,在某些特定的领域中 – 例如信用评分或医疗健康中 – 需要模型可以被解释。 在某些应用领域(包括自动驾驶汽车或医疗应用),安全性和估计误差是至关重要的。 当我们在许多种现实世界的情况中部署机器学习时,仅仅优化统计指标或商业指标是不够的。 数据科学界越来越多地参与着两个主题,这两个主题正是我想在本文其余部分讨论的:机器学习中的隐私和公平。

隐私和安全

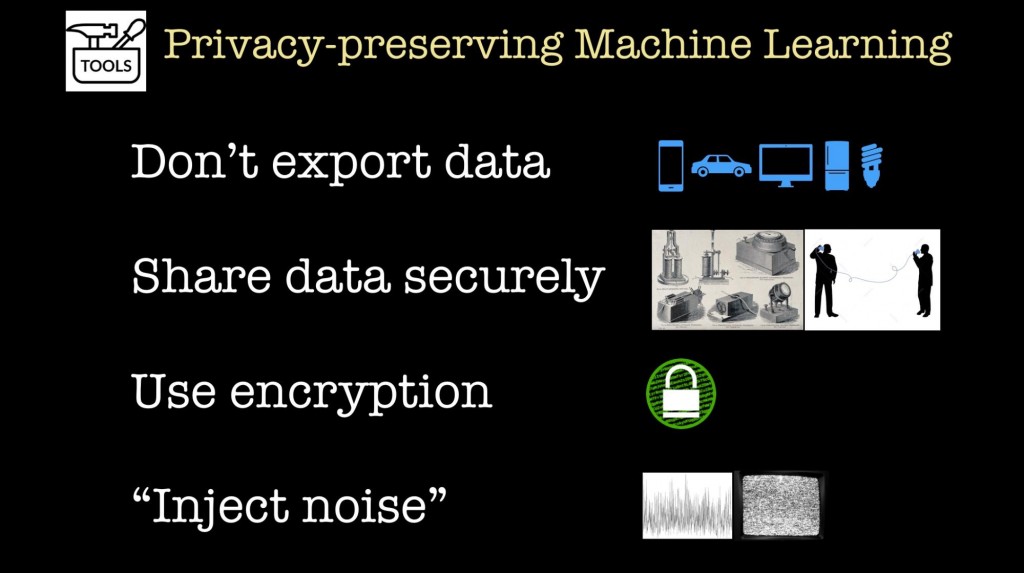

鉴于用户和监管机构对数据隐私的兴趣日益增长,人们对能够在保护数据隐私的同时构建机器学习模型的工具产生了浓厚的兴趣。 这些工具依赖于构建它们的组件模块,我们开始看到组合了许多组件模块的工作系统。 其中一些工具是开源的,可供更广泛的数据社区使用:

- 当您想要在不共享私有数据的情况下协作构建中心化的模型时, 联合学习非常有用。 它已经在谷歌的生产环境中被使用,但我们仍然需要工具来保证联合学习是广泛可用的。

- 我们开始看到允许您在构建模型的同时保障差分隐私,这是在隐私领域最流行、最强大的概念之一。 在更高的角度来看,这些方法在模型构建过程的不同阶段注入随机噪声。 这些新兴的工具集旨在让已经正在使用scikit-learn和TensorFlow等库的数据科学家可以使用。 希望数据科学家很快能够定期构建查分隐私模型。

- 有一小部分数量持续增长的研究人员和企业家,正在研究是否可以在加密数据上构建或使用机器学习模型。 在过去的一年中,我们已经看到了用于快速同态加密的开源库(HElib和Palisade),初创公司们正在这些库之上构建机器学习工具和服务。 这里的主要瓶颈是速度:许多研究人员正在积极研究硬件和软件工具,这些工具可以加速加密数据的模型推断(甚至模型构建)。

- 安全的多方计算是该领域中使用的另一类很有前景的技术。

公平性

现在让我们考虑一下公平性。 在过去的几年里,许多机器学习研究人员和从业者已经开始研究和开发有助于确保机器学习模型公平公正的工具。 就在前几天,我搜索谷歌最近关于人工智能的新闻报道,我对涉及公平的文章数量感到惊讶。

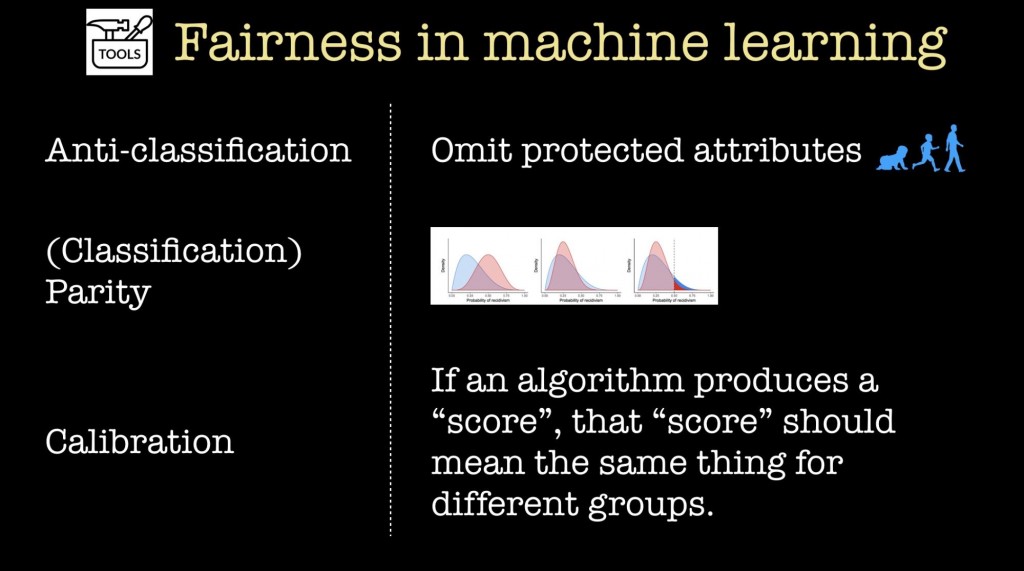

对于本节的其余部分,我们假设某人正在建立一个分类器,并且某些变量被认为是“受保护的属性”(这可能包括年龄,种族,性别等等)。 事实证明,机器学习研究界已经使用许多数学标准来定义分类器的公平性意味着什么。幸运的是,最近斯坦福大学的一份研究报告——公平的机器学习评论——简化了这些标准,并将这些衡量标准分为以下几类:

- 抗分类是指从模型或分类器中省略受保护的特征及其代理变量 。

- 分类平衡性意味着,一个或多个标准性能指标(例如,假阳性和假阴性率,准确度,召回率)在不同受保护特征形成的组之间是相同的。

- 校准 :如果算法产生了一个“分数”,针对不同群体相同的分数应该意味着同样的事情。

然而,正如斯坦福大学的作者在他们的论文中指出的那样,上述每种数学上的形式化定义都存在着局限性。 在公平性方面,没有黑箱或套路可以将你的算法套用进去,并产生一个清晰的诊断。不存在所谓一劳永逸的通用流程。

正因为没有铁打的流程,你需要一个团队,让数据管线循环包含真人。公平性的这种提法不仅对不同领域和问题背景是不同的,而且正如加州大学伯克利分校的研究人员最近指出的那样,还存在着一个时间维度(“我们主张在’公平’机器学习的讨论中寻求长期结果” )。 我们需要的是能够查询数据并了解潜在的分布数据科学家,他们可以与有能力全面评估模型的领域专家一起工作。

文化和组织

随着我们部署更多模型,很明显我们需要考虑优化统计和业务指标。虽然我在这篇短文中没有涉及到它们,但很明显,可靠性和安全性随着发展的进行,非常重要。 在机器学习模型必须考虑许多其他重要事项的世界中,您该如何建立和组织您的团队?

幸运的是,我们的数据社区成员一直在考虑这些问题。 隐私论坛的未来和Immuta最近发布了一份报告,其中提出了一些很棒的建议,这些建议是关于如何带着风险管理的意识处理机器学习项目的:

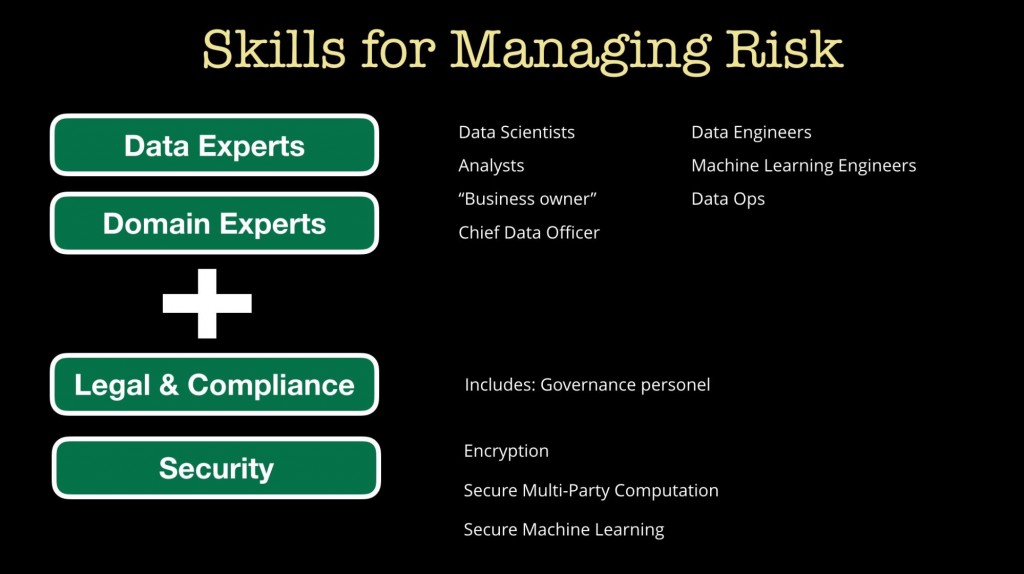

- 当您从事机器学习项目时,您需要聘请数据工程师,数据科学家和领域专家。

- 报告中概述的一个重要变化是,需要一组独立于该模型构建团队的数据科学家。 然后,这个“验证者”团队可以负责用可解释性,隐私性和公平性等等来评估机器学习模型。

结束语

那么,在机器学习模型日益重要的世界中,哪些技能是被需要的呢? 如上所述,公平性审计将需要一组数据专家和领域专家的混合团队。 事实上, 最近对NBER职位发布的分析发现,与其他数据分析技能相比,机器学习技能往往与领域知识捆绑在一起。

不过,除了您的数据专家和领域专家以外,您还需要法律和安全专家一起补充您的团队。 展望未来,我们需要让法律、合规、数据安全人员与数据科学家、数据工程师更紧密地合作。

这个结论不应该令人震惊:我们已经在桌面安全,网络安全和移动安全进行投资。 如果机器学习要通吃软件行业,我们就需要努力解决人工智能和机器学习的安全问题。

相关内容:

- Sharad Goel和Sam Corbett-Davies谈到“为什么设计公平的机器学习模型很困难”

- Alon Kaufman谈“加密数据上的机器学习”

- Chang Liu谈“隐私保护技术如何带来更强大的机器学习模型”

- “如何在数据隐私变得至关重要的时代构建分析产品”

- “隐私和机器学习时代的数据收集和数据市场”

- “对软件开发而言机器学习意味着什么”

- “将机器学习模型转化为真实的产品和服务中学到的经验教训”

2019年6月18-21日在北京举行的人工智能大会议题征集已经开始。